Xin chào bạn!

Hôm nay mình bước vào một chủ đề mới nhưng cực kỳ quan trọng đó là hallucination (AI “bịa” thông tin) và dữ liệu lỗi thời. Mình đã từng mừng húm vì một câu trả lời có vẻ rất chắc nịch… rồi sau đó phát hiện nó sai bét. Bài học hôm nay sẽ là hiểu rõ giới hạn của mô hình để đặt prompt khôn ngoan hơn.

Mình sẽ nói rõ hơn ở phần chi tiết bên dưới để tránh bị AI lừa nhé, không phải lúc nào AI cũng đúng đâu. Bắt đầu thôi!

Ảnh minh họa Giới Hạn Của Mô Hình: Hallucination & Dữ Liệu Lỗi Thời

Mục Tiêu Chính Hôm Nay

- Hiểu hallucination là gì, vì sao xảy ra và tác hại của nó.

- Biết dấu hiệu nhận biết khi AI “bịa” hoặc trả lời thiếu căn cứ.

- Phân biệt dữ liệu lỗi thời vs. thiếu dữ liệu thời gian thực.

- Nắm các chiến lược giảm thiểu: yêu cầu trích nguồn, cho phép nói “không biết”, thêm ràng buộc rõ ràng. (xem thêm: [Ngày 32] – Sức Mạnh Của “KHÔNG”: Giới Thiệu Negative Constraints để biết cách thêm ràng buộc)

- Thực hành viết prompt để kiểm tra và giảm thiểu hallucination.

Xem thêm một số bài học trước nhé:

- [ngày 29] Zero-shot Prompting: Khai Phá Sức Mạnh AI Từ Con Số 0

- [Ngày 30] Few-shot Prompting: Khi AI Học Hỏi Từ Ví Dụ

- [Ngày 31] Phân Biệt & Lựa Chọn: Zero-shot và Few-shot

- [Ngày 32] – Sức Mạnh Của “KHÔNG”: Giới Thiệu Negative Constraints

Giới Hạn Của Mô Hình và Hallucination là gì?

- Khái niệm: là khi mô hình tự tin đưa ra thông tin không có thật hoặc không được kiểm chứng.

- Vì sao xảy ra: Cơ chế của mô hình là dự đoán từ tiếp (xem lại bài 2 AI hoạt động như thế nào? Tò mò “bộ não AI” từ bên trong) theo dựa trên mẫu dữ liệu đã học; khi thiếu dữ kiện, nó có xu hướng điền vào chỗ trống. ChatGPT là chúa nhé, rất hay bịa. Cẩn thận nếu không muốn bị nó dắt mũi. 😀

- Tác hại: Gây hiểu lầm, quyết định sai, mất uy tín nội dung.

Dấu hiệu nhận biết nhanh

- Câu trả lời rất chắc chắn nhưng không có nguồn.

- Tên người/sự kiện/định nghĩa nghe lạ mà quen.

- Số liệu tròn trịa quá mức (ví dụ “chính xác 50% mọi trường hợp”).

- Khi hỏi lại nguồn, AI vòng vo hoặc trích nguồn không tồn tại.

Dữ Liệu Lỗi Thời (Outdated Information)

- Mô hình không có thời gian thực: kiến thức dừng ở một mốc huấn luyện.

- Hệ quả: Trả lời sai với các chức danh hiện tại, giá cả, sự kiện mới, địa điểm mới. ( ví dụ các tỉnh mới của Việt Nam sau khi sáp nhập)

- Lưu ý: Ngay cả khi mô hình có khẳng định đã cập nhật mới nhất, bạn vẫn cần xác minh (verification).

Theo kinh nghiệm của mình là, nếu một thông tin cần câu trả lời chính xác tuyệt đối, hãy copy prompt đặt vào từ 2-3 AI trở lên để kiểm chứng, hoặc lấy câu trả lời của AI này và hỏi AI khác xem có đúng không. Tốn chút time nhưng lại cần thiết nhé!

Prompt nào dễ kích ảo giác?

- Câu hỏi quá mơ hồ (“Kể thêm vài sự thật thú vị về X” khi X ít tư liệu).

- Ép trả lời dù không có dữ liệu (“Dù không chắc, hãy đoán”).

Ví dụ: “bạn hãy dự đoán giá bitcoin năm 2030, nếu không có dữ liệu, hãy dự đoán theo ý bạn” -> lúc này AI tha hồ mà chém gió.

Ngược lại nếu bạn muốn AI trả lời theo cách khác, hãy thêm ràng buộc

Ví dụ: “bạn hãy dự đoán giá bitcoin năm 2030, nếu không có dữ liệu, có thể trả lời không biết” -> bạn thử prompt này và so với kết quả của prompt trên nhé - Thiếu ràng buộc về nguồn, về bằng chứng, hoặc cho phép AI nói thả ga.

Khi sử dụng nhiều chatbot như GPT, Grok, Gemini hay Perlexity… để phục vụ cho công việc, mình nhận ra mỗi con có điểm mạnh riêng. Riêng về tra cứu thông tin cần nguồn hay link dẫn chứng mình đặc biệt thích Perlexity và Claude.ai

Chiến Lược Giảm Thiểu Sai kết quả từ AI (Hallucination)

- Cho phép không biết: “Nếu không chắc 100%, hãy nói không biết.”

- Yêu cầu trích dẫn: “Chỉ dùng thông tin có thể trích nguồn đáng tin cậy.”

- Ràng buộc phủ định (Negative Constraints): “Đừng bịa tên nghiên cứu/nhân vật.”

- Hạn chế phạm vi: “Trả lời trong phạm vi 2018–2022.”

- Nhắc xác minh: “Nêu độ tin cậy và cách kiểm chứng.”

Mẫu prompt có thể tái dùng:

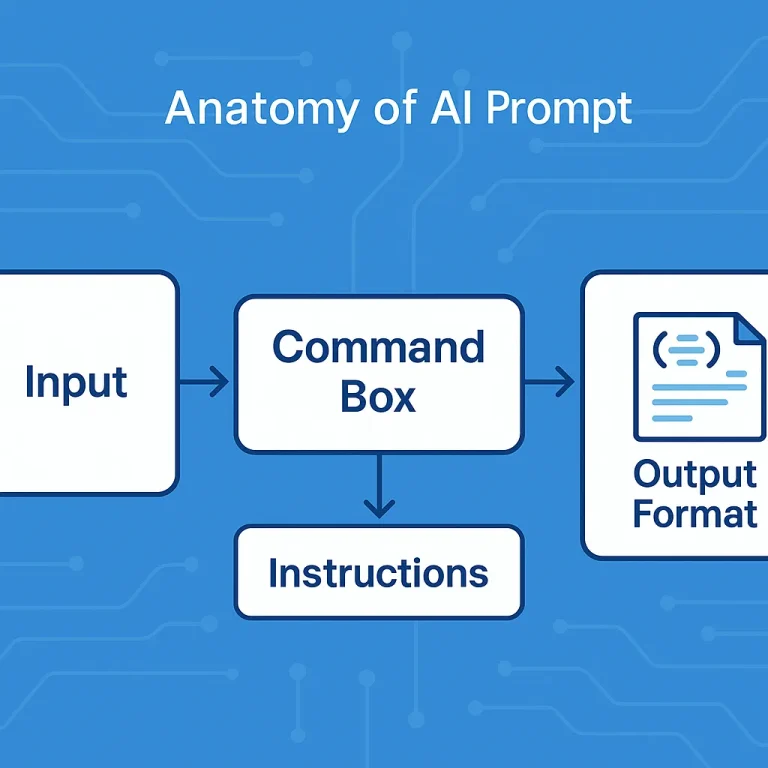

[Instruction] Trả lời câu hỏi sau bằng dữ kiện đã kiểm chứng.

[Constraint] Nếu không chắc, hãy nói “Không biết/Không có thông tin xác thực.”

[Constraint] Không bịa nguồn, không suy đoán tên người/sự kiện.

[Output] Trình bày: (1) Câu trả lời ngắn, (2) 2–3 nguồn tham khảo (nếu có), (3) Mức độ tin cậy 1–5.

[Question] ...

Với mẫu này bạn có thể yên tâm AI sẽ không dám bịa bất kỳ thông tin nào nếu không có nguồn hay dữ liệu được học.

Thực Hành

Bài 1 – Kiểm tra Hallucination

Mục tiêu: Nhận diện khi AI “bịa”.

Prompt gợi ý:

Hãy trả lời câu hỏi sau. Nếu thông tin không tồn tại, hãy nói “Không có dữ liệu xác thực”.

Câu hỏi: Ai là người phát minh ra phương pháp teleportation vào năm 2024?

Việc cần làm: Bằng việc đưa ra câu hỏi mà bạn đã biết câu trả lời, sau đó quan sát liệu AI có bịa ra tên người/nhóm nghiên cứu hay không.

Bài 2 – Kiểm tra Dữ Liệu Lỗi Thời

Mục tiêu: Phát hiện hạn chế cập nhật thời gian thực.

Prompt gợi ý:

Ai là thủ tướng hiện tại của nước Anh?

Nếu bạn không nắm dữ liệu cập nhật, hãy nói “không chắc” và đề xuất cách kiểm chứng.

Việc cần làm: So sánh câu trả lời với nguồn đáng tin (trang chính phủ, báo lớn), ghi chú sai lệch (nếu có).

Bài 3 – Viết Prompt “Chống Ảo Giác”

Mục tiêu: Thêm ràng buộc để giảm thiểu sai thông tin.

Prompt gợi ý:

Bạn là trợ lý nghiên cứu thận trọng.

Nhiệm vụ: Tóm tắt khái niệm “reinforcement learning” cho người mới.

Ràng buộc:

- Không bịa thuật ngữ/nhân vật/niên đại.

- Nếu thiếu dữ liệu, nói “không chắc” và gợi ý nguồn kiểm chứng.

- Thêm 2 tài liệu nhập môn uy tín (nếu nhớ).

Định dạng: 3 gạch đầu dòng + 1 ghi chú kiểm chứng.

Chịu khó thực hành và tạo ra các ràng buộc cho AI, mình tin khả năng ra lệnh cho AI của bạn sẽ tăng lên đáng kể sau một thời gian sử dụng nó. Bởi vậy mới có câu “Người sử dụng AI là một nghệ sĩ… haha”. Câu đó tui nói!

5 Từ Vựng Tiếng Anh Chuyên Ngành Hôm Nay

| Từ vựng | Nghĩa | Ví dụ ứng dụng |

|---|---|---|

| Hallucination | Ảo giác thông tin | LLMs can sometimes experience hallucination. |

| Outdated | Lỗi thời | The model might provide outdated information. |

| Limitation | Giới hạn | Understanding model limitations is crucial. |

| Verification | Xác minh | Always perform verification of AI-generated facts. |

| Reliable | Đáng tin cậy | Strive to make your prompts generate reliable output. |

Trò Chuyện Cùng ChatGPT (luyện phản xạ)

Sau khi bạn viết prompt và có kết quả từ AI, hãy dùng những mẫu câu bên dưới để xác minh:

- “Hãy đánh giá câu trả lời sau về mức độ tin cậy (1–5) và cho biết vì sao.”

- “Bạn có đang suy đoán phần nào trong câu trả lời không? Nếu có, hãy đánh dấu.”

- “Liệt kê 3 cách mình có thể xác minh nội dung này bên ngoài.”

Ghi Chú & Cảm Nhận Của Mình

Hôm nay mình nghiệm ra: viết prompt rõ ràng, có giới hạn và cho phép AI nói “không biết” làm chất lượng tăng hẳn. Cảm giác an toàn hơn nhiều khi bài có phần xác minh và mức độ tin cậy. Từ nay, với mỗi prompt, mình sẽ mặc định thêm một dòng “nếu không chắc, hãy nói không biết”. Đây là cách nhận được kết quả tốt nhất

Checklist Ngày 34

- Mình đã hiểu được lý thuyết về hallucination và dữ liệu lỗi thời là gì.

- Thực hành kiểm tra và giảm thiểu hallucination.

- Học 5 từ vựng chuyên ngành hôm nay. Vẫn chưa thuộc lắm!

- Trò chuyện nhanh với ChatGPT/Gemini để đánh giá mức tin cậy của một câu trả lời.

- Ghi chú lại mẫu prompt chống ảo giác bạn thấy hữu ích nhất.

Tổng Kết Ngày 34

Qua bài này, mình hiểu giới hạn của mô hình, nhưng không vì thế mà mất niềm tin vào AI, mà hiểu được để sử dụng AI thông minh hơn. Từ nay, mỗi khi cần độ chính xác, mình sẽ bật “chế độ cẩn trọng”: yêu cầu trích nguồn, cho phép nói “không biết”, và ghi rõ mức độ tin cậy.

Bạn đã từng gặp một màn ảo giác nào đáng nhớ chưa? Bình luận chia sẻ nhé, mình cùng mổ xẻ và viết lại prompt cho chuẩn chỉ hơn!

Vẫn là câu nói muôn thuở, nếu bạn có thắc mắc gì về bài viết, cứ để lại câu hỏi trong phần bình luận, mình sẽ trả lời trong khả năng nhé.

Chào thân ái!